Als Unternehmer stehen Sie täglich vor rechtlichen Entscheidungen, die den Markteintritt und die Skalierung Ihrer KI-Systeme bestimmen. Der EU Artificial Intelligence Act (kurz KI-Verordnung oder AI Act) definiert erstmals verbindliche Regeln für Künstliche Intelligenz – abgestuft nach dem Risiko, das ein System für Gesundheit, Sicherheit oder die Grundrechte natürlicher Personen birgt.

AI Act Hochrisiko Systeme stehen dabei im Fokus der Regulierung: KI-Anwendungen in sensiblen Bereichen wie Medizin, Personalentscheidungen oder Kreditvergabe unterliegen umfassenden Dokumentationspflichten und Nachweispflichten, um transparente und vertrauenswürdige KI-Lösungen zu gewährleisten. Für Sie als Anbieter oder Betreiber solcher Systeme stellt sich die zentrale Frage: Welche Hochrisiko-KI trifft die KI-Verordnung wie, welche Pflichten gelten ab wann – und wie dokumentieren Sie rechtskonform?

Key Takeaways

- Risikoklassifizierung: Die EU‑KI‑Verordnung ordnet KI‑Systeme in verbotene, Hochrisiko-KI-Systeme , begrenzte und minimale Risiken ein. Hochrisiko‑Bereiche sind u. a. biometrische Identifizierung, kritische Infrastrukturen, Bildung, Beschäftigung, Kreditvergabe, Strafverfolgung und Justiz (nach Anhang III EU‑KI‑Verordnung)

- Umfangreiche Dokumentationspflichten. Anbieter hochriskanter KI müssen eine technische Dokumentation erstellen, die u.a. Systembeschreibung, Zweck, Algorithmus-Design, Datensätze, Leistungsbewertungen und Risikoanalysen umfasst. Diese Dokumentation muss regelmäßig aktualisiert und bei Änderungen angepasst werden.

- Aufbewahrung und Protokollierung. Alle relevanten Aufzeichnungen und automatischen Protokolle des KI-Systems sind mindestens 10 Jahre aufzubewahren. Betreiber müssen System-Logs mindestens 6 Monate lang speichern, um eine Nachverfolgung von Entscheidungen zu ermöglichen.

- Weitere Pflichten für Hochrisiko-KI. Neben Dokumentation gelten Anforderungen an Risikomanagement (Art. 9), Datenqualität (Art. 10), Transparenz & Nutzerinformationen (Art. 13), menschliche Aufsicht (inkl. "Stop-Knopf") sowie Cybersicherheit. Außerdem ist vor dem Inverkehrbringen eine Konformitätsbewertung mit Erstellung einer EU-Konformitätserklärung und CE-Kennzeichnung vorgeschrieben.

- Strenge Durchsetzung, aber Start-up-Sandbox. Die Überwachung übernimmt in Deutschland voraussichtlich die Bundesnetzagentur (mit branchenspezifischer Unterstützung, z.B. BaFin für Finanz-KI). Verstöße können Bußgelder bis zu 35 Mio. € oder 7 % des Umsatzes nach sich ziehen. Gleichzeitig sollen KI-Reallabore (Sandbox-Programme) KMU und Start-ups ermöglichen, KI-Systeme vor Markteinführung in kontrollierter Umgebung zu testen.

Die EU hat mit dem AI Act einen risikobasierten Rechtsrahmen geschaffen: Je höher das Risiko eines KI-Systems, desto strenger die Auflagen. Für Hochrisiko-KI-Systeme gilt ab August 2026 ein umfassendes Pflichtenprogramm – von der technischen Dokumentation über automatische Protokollierung bis zur Konformitätsbewertung mit CE-Kennzeichnung. Verstöße können Geldbußen bis zu 35 Mio. € oder 7% des weltweiten Jahresumsatzes nach sich ziehen.

Dieser Artikel liefert Ihnen Grundlagen und den Überblick: Sie erfahren, welche KI-Systeme als hochriskant gelten, welche Inhalte Ihre technische Dokumentation umfassen muss, wie lange Aufzeichnungen aufzubewahren sind und welche weiteren Compliance-Anforderungen (Risikomanagement, Transparenz, menschliche Aufsicht) Sie erfüllen müssen. Zudem zeigen wir Ihnen, welche Erleichterungen für Start-ups vorgesehen sind (z.B. KI-Reallabore) und wie Sie die Dokumentationspflichten strategisch als Wettbewerbsvorteil nutzen können.

Für KI-Startups bedeutet das konkret: Dokumentation by Design – integrieren Sie Compliance-Prozesse von Anfang an in Ihre Entwicklung, statt nachträglich aufwendig nachzurüsten. Wer die AI-Act-Vorgaben frühzeitig umsetzt, sichert sich nicht nur rechtliche Compliance, sondern schafft Vertrauen bei Kunden, Investoren und Partnern – und positioniert sich zukunftssicher im europäischen KI-Markt.

Was sind Hochrisiko-KI-Systeme?

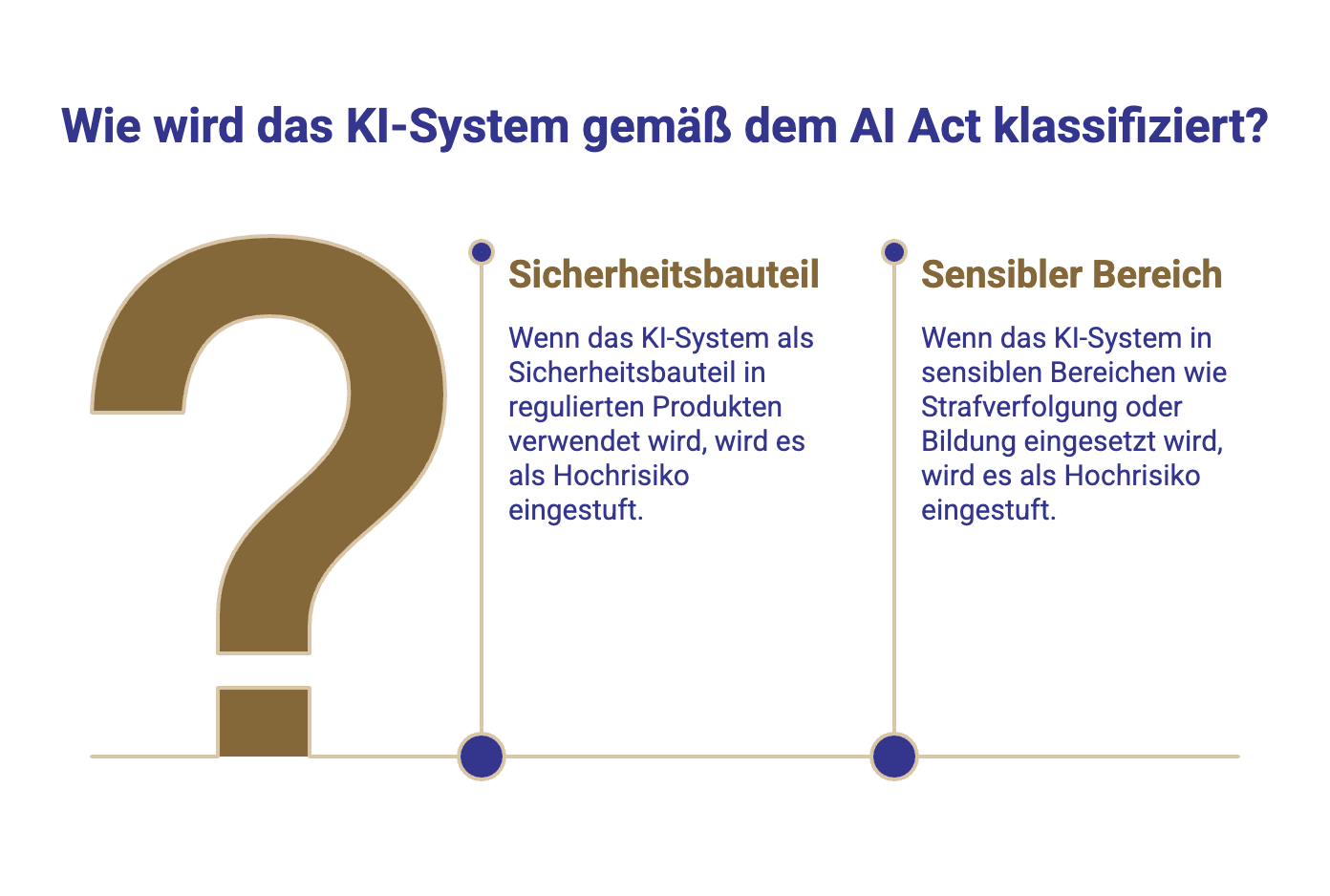

Der AI Act verfolgt einen risikobasierten Ansatz: Je höher die Wahrscheinlichkeit, dass Gesundheit, Sicherheit oder Grundrechte natürlicher Personen beeinträchtigt werden, desto strenger die Vorschriften. Hochrisiko‑KI‑Systeme sind nach dem Gesetz vor allem:

- KI als Sicherheitsbauteil in bereits regulierten Produkten nach EU‑Harmonisierungsrechtsvorschriften (z. B. Medizinprodukte, Maschinen, Spielzeug) – die zweckbestimmung und sicherheitsrelevante Funktion der Systeme löst hier die Hochrisiko‑Einstufung aus.

- KI‑Systeme in sensiblen Bereichen nach Anhang III etwa biometrische Fernidentifizierung, kritische Infrastrukturen (z. B. Verkehr, Energie), Bildung, Beschäftigung/Personalverwaltung, Kreditvergabe/Sozialleistungen, Strafverfolgung, Migration/Asyl und Justiz

Die KI‑Verordnung definiert KI‑System als softwarebasiertes System, das zumindest teilweise autonom arbeitet und aus Eingaben Ergebnisse (Vorhersagen, Entscheidungen, Empfehlungen, Inhalte) erzeugt. Entscheidend ist der Anwendungsbereich und das Ergebnis der Entscheidungsfindung wesentlich für Gesundheit, Sicherheit oder die Grundrechte – dann greift die Einstufung als Hochrisiko‑KI.

Praxishinweis: Nicht jedes generative KI‑Modell oder jeder Chatbot ist automatisch Hochrisiko‑KI. Transparenzpflichten gelten zwar auch für KI mit begrenztem Risiko (z. B. Hinweise für natürliche Personen, wenn sie mit KI interagieren), doch die strengen Kapitel‑III‑Pflichten sind den Hochrisiko‑KI‑Systemen vorbehalten.

KI-Modelle und Risikoklassen

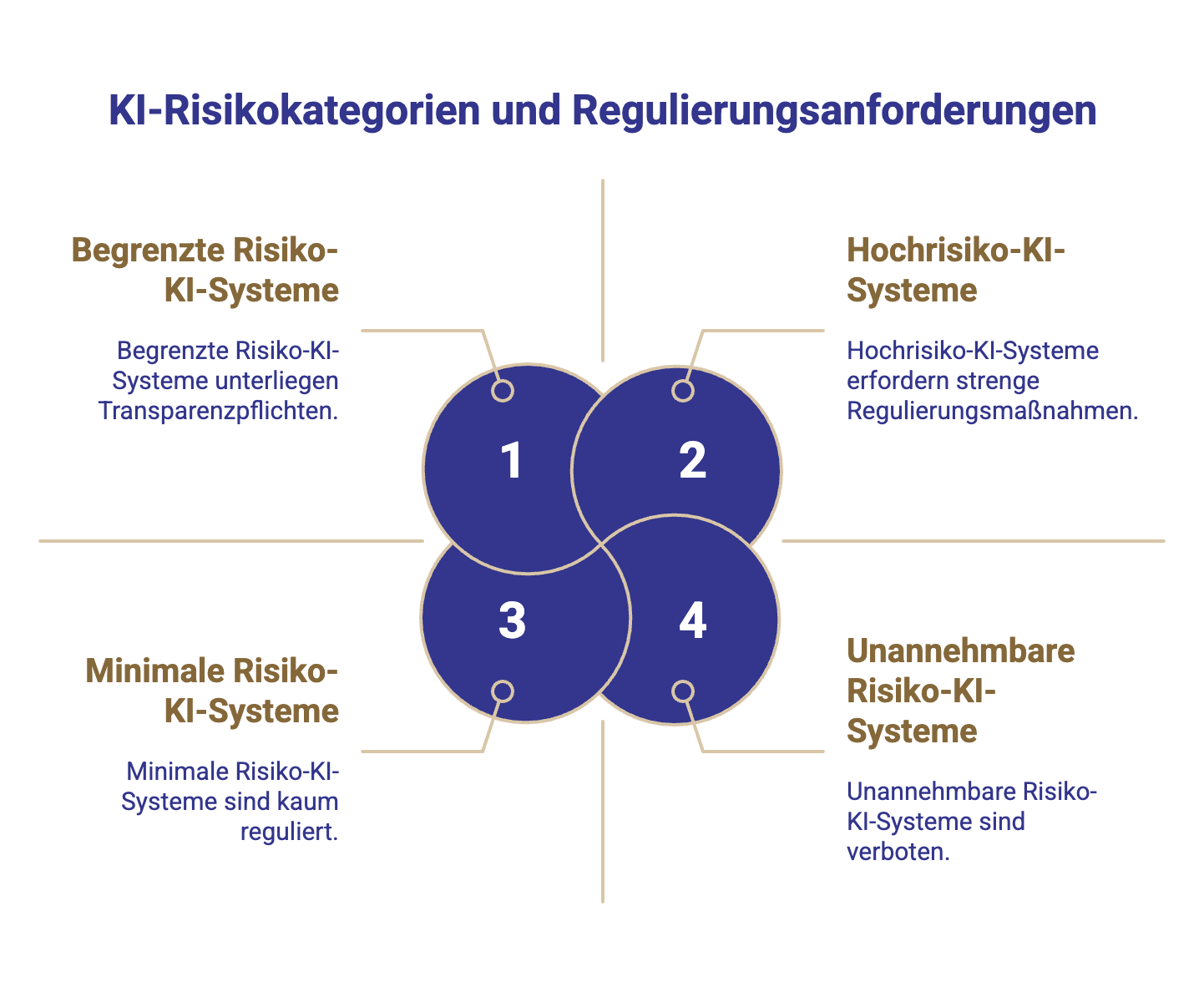

Zunächst unterscheidet die Verordnung vier Stufen:

- Unannehmbares Risiko – bestimmte KI-Praktiken sind verboten, etwa Social Scoring oder manipulative KI-Spielzeuge.

- Hochrisiko – hierunter fallen KI-Systeme, die die Gesundheit, Sicherheit oder Grundrechte erheblich beeinträchtigen können.

- Begrenztes Risiko – Systeme mit moderatem Risiko (z.B. Chatbots, Deepfakes) unterliegen nur Transparenz- und Kennzeichnungspflichten.

- Minimales Risiko – triviale KI-Anwendungen (Spamfilter, Videospiele) sind kaum reguliert und lediglich durch freiwillige Verhaltenskodizes abgedeckt.

Klassifizierung von KI-Systemen nach Risikostufen gemäß EU AI Act

Pflichten für Hochrisiko-KI-Systeme im Überblick

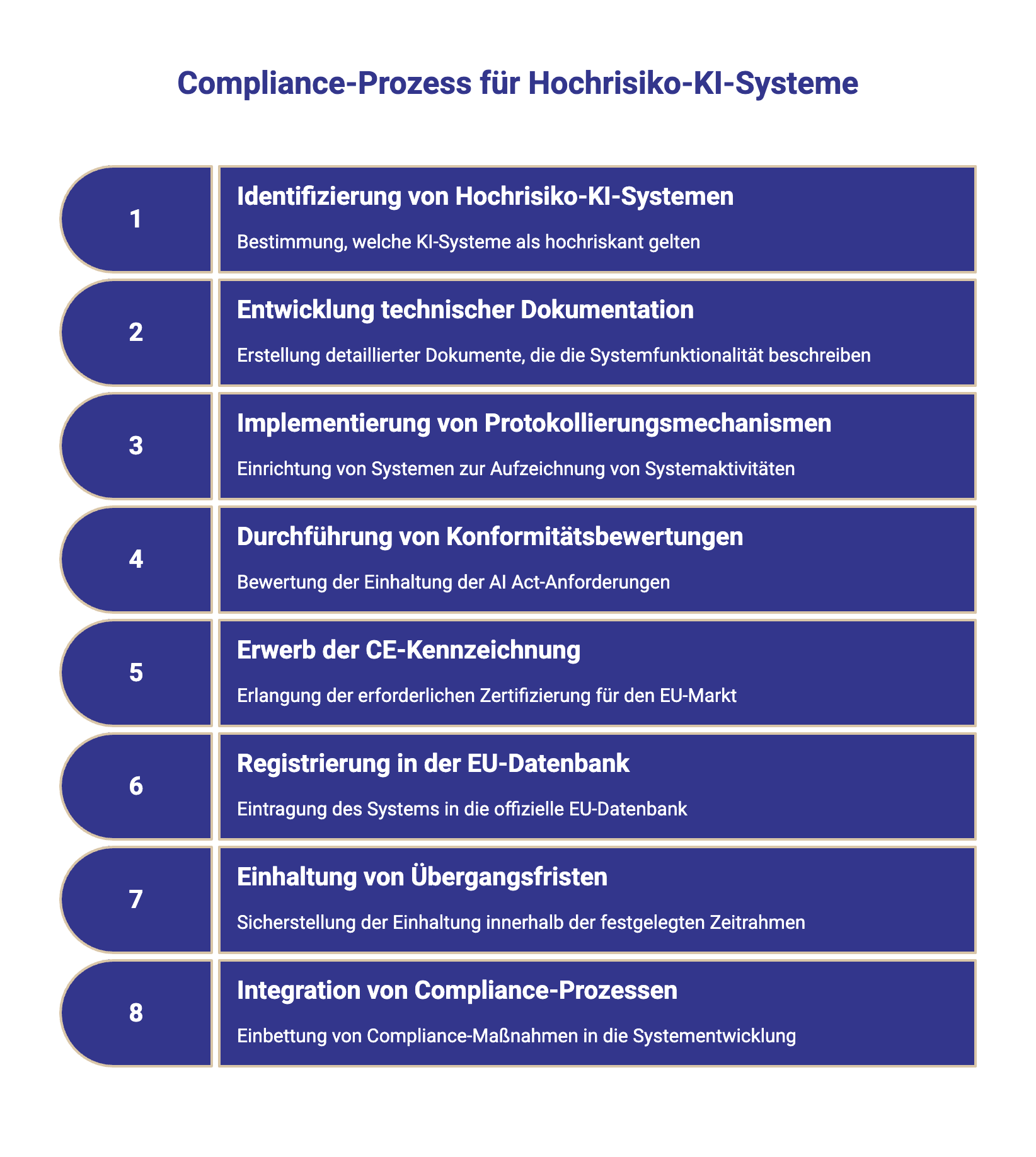

Wer ein Hochrisiko-KI-System anbietet (entwickelt und auf den Markt bringt) oder betreibt (in eigener Verantwortung verwendet), muss ab Inkrafttreten der KI-Verordnung ein umfangreiches Pflichtenprogramm erfüllen. Die Anforderungen sind in Kapitel III AI Act detailliert beschrieben und lassen sich grob in technische, organisatorische und dokumentarische Pflichten unterteilen:

- Risikomanagement (Art. 9): Kontinuierlicher Prozess über den gesamten Lebenszyklus: Gefährdungen der Gesundheit, Sicherheit oder Grundrechte natürlicher Personen identifizieren, bewerten, mitigieren und dokumentieren.

- Daten‑ & Qualitätsmanagement (Art. 10): Geeignete, repräsentative, fehlerarme Daten; Governance der Datensätze zur Bias‑Minimierung.

- Technische Dokumentation (Art. 11): Vollständiges technisches Dossier gem. Anhang IV

- Protokollierung (Art. 12): Automatisierte Logs wesentlicher Systemereignisse; Aufbewahrungspflichten (siehe Art. 26 für Betreiber)

- Transparenz & Nutzerinformationen (Art. 13): Klare Gebrauchsanweisung, Leistungsgrenzen, sichere Bedingungen für den Betrieb; Hinweis‑Pflichten gegenüber natürlicher Personen bei KI‑Interaktionen.

- Menschliche Aufsicht (Art. 14): Effektive Überwachung durch natürliche Personen inkl. Notabschaltung (“Stop‑Button”).

- Genauigkeit/Robustheit/Cybersicherheit (Art. 15): Nachweisbare Sicherheit, Resilienz, definierte Fehlerraten.

Diese Übersicht zeigt, dass Dokumentationspflichten nur ein – wenn auch zentrales – Element eines umfassenden Compliance-Rahmens sind. Gerade KI-Startups sollten die Wechselwirkungen beachten: Eine saubere Dokumentation stützt z.B. das Risikomanagement (Gefährdungen dokumentieren und mindern) und erleichtert die Transparenz gegenüber Kunden und Aufsichtsbehörden.

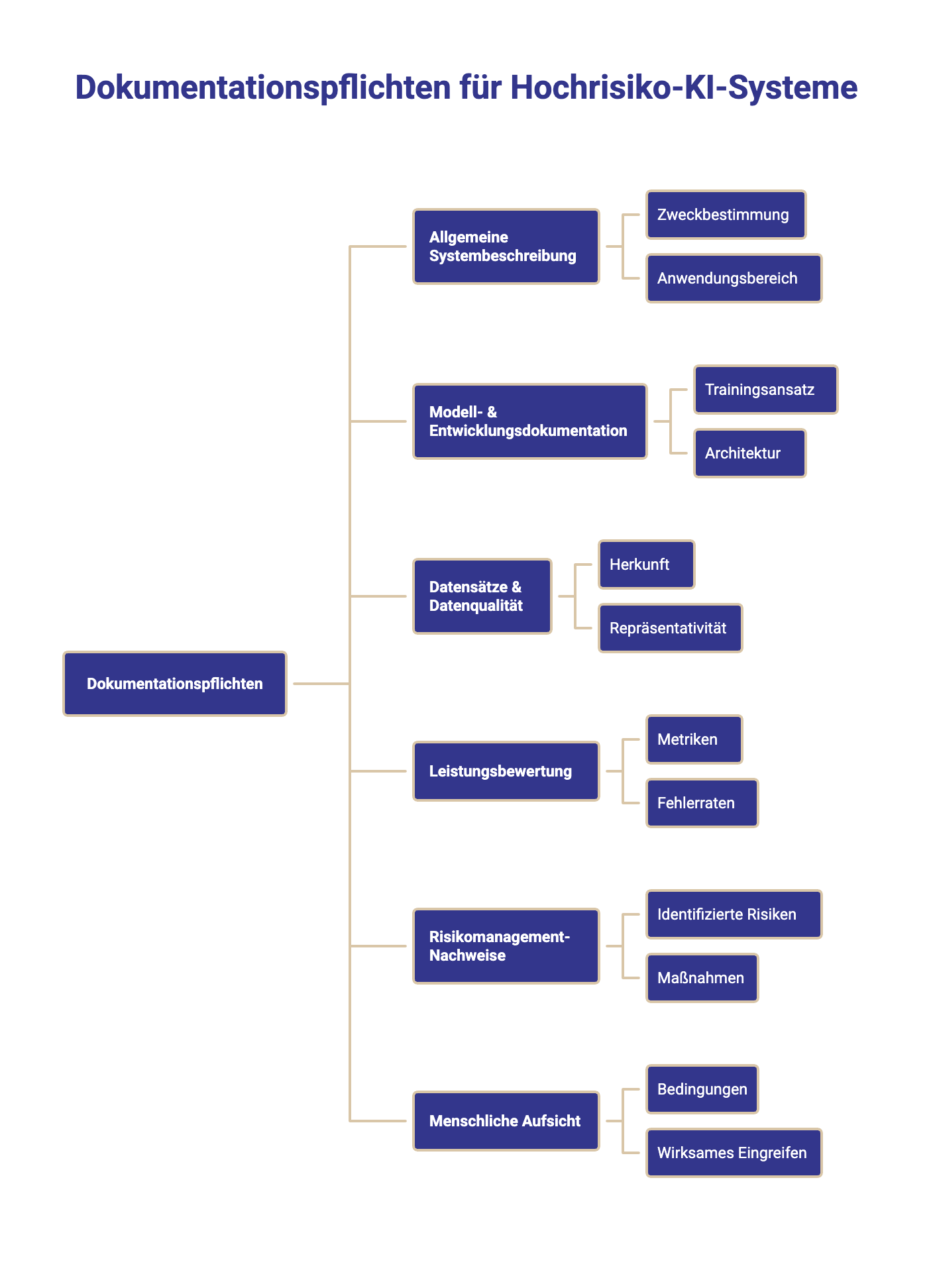

Dokumentationspflichten nach dem AI Act im Detail

Ein zentrales neues Compliance-Element des AI Act ist die umfassende Dokumentationspflicht für Hochrisiko-KI-Systeme. Dabei geht es um zweierlei: (1) die technische Dokumentation des KI-Systems durch den Anbieter und (2) die Protokollierung von Systemvorgängen sowie Aufbewahrung relevanter Aufzeichnungen. Beide dienen als Nachweis, dass das KI-System den gesetzlichen Anforderungen entspricht und sicher betrieben wird.

Technische Dokumentation (Art. 11 KI-VO)

Artikel 11 verpflichtet Anbieter, vor Markteinführung eine "vollständige Beschreibung der Funktionalität" des KI-Systems zu erstellen – quasi ein technisches Dossier, das alle Phasen des KI-Lebenszyklus abdeckt. Diese technische Dokumentation muss laut Gesetz folgende Inhalte mindestens abdecken:

- Allgemeine Systembeschreibung: Zweck/zweckbestimmung, Anwendungsbereich, Versionen, Abhängigkeiten, Sicherheitsbauteil‑Funktionen.

- Modell‑ & Entwicklungsdokumentation: Trainingsansatz, Architektur, eingesetzte KI‑Modelle, Abwägungen (z. B. Genauigkeit vs. Fairness), verwendete Produkten‑Umgebungen.

- Datensätze & Datenqualität: Herkunft, Repräsentativität, Vorverarbeitung, Label‑Prozesse; Governance zur Bias‑Reduktion.

- Leistungsbewertung: Metriken, Fehlerraten je Anwendungsfälle, Robustheitstests – hinblick auf Sicherheit und Grundrechte natürlicher Personen.

- Risikomanagement‑Nachweise: identifizierte Risiken, Maßnahmen, Rest‑Risiko.

- Menschliche Aufsicht: Bedingungen, unter denen natürliche Personen wirksam eingreifen können.

- Änderungsprotokoll/Versionierung: Updates, Retrainings, Absatz‑/Artikel‑Bezüge.

- Standards/Normen: Bezug zu (künftigen) Normen/Leitlinien; siehe Bitkom‑Leitfaden mit Normenüberblick.

Laufende Aktualisierung, Aufbewahrung, Zugriff der Behörden

Die Dokumentation ist lebendiges Material: Änderungen an KI‑Systemen (neue Daten, neue Modelle, neue Bedingungen) sind zeitnah einzupflegen. Anbieter müssen die Unterlagen 10 Jahre aufbewahren und behördlich vorlegen können.

Das entspricht dem Lebenszyklus‑Ansatz der KI‑Verordnung: Sicherheit oder die Grundrechte müssen dauerhaft gewahrt bleiben – nicht nur zum Zeitpunkt der Markteinführung.

Organisationstipp: Verankern Sie Doku‑Pflege in Ihrem DevOps – jede Release‑Änderung triggert einen Compliance Check.

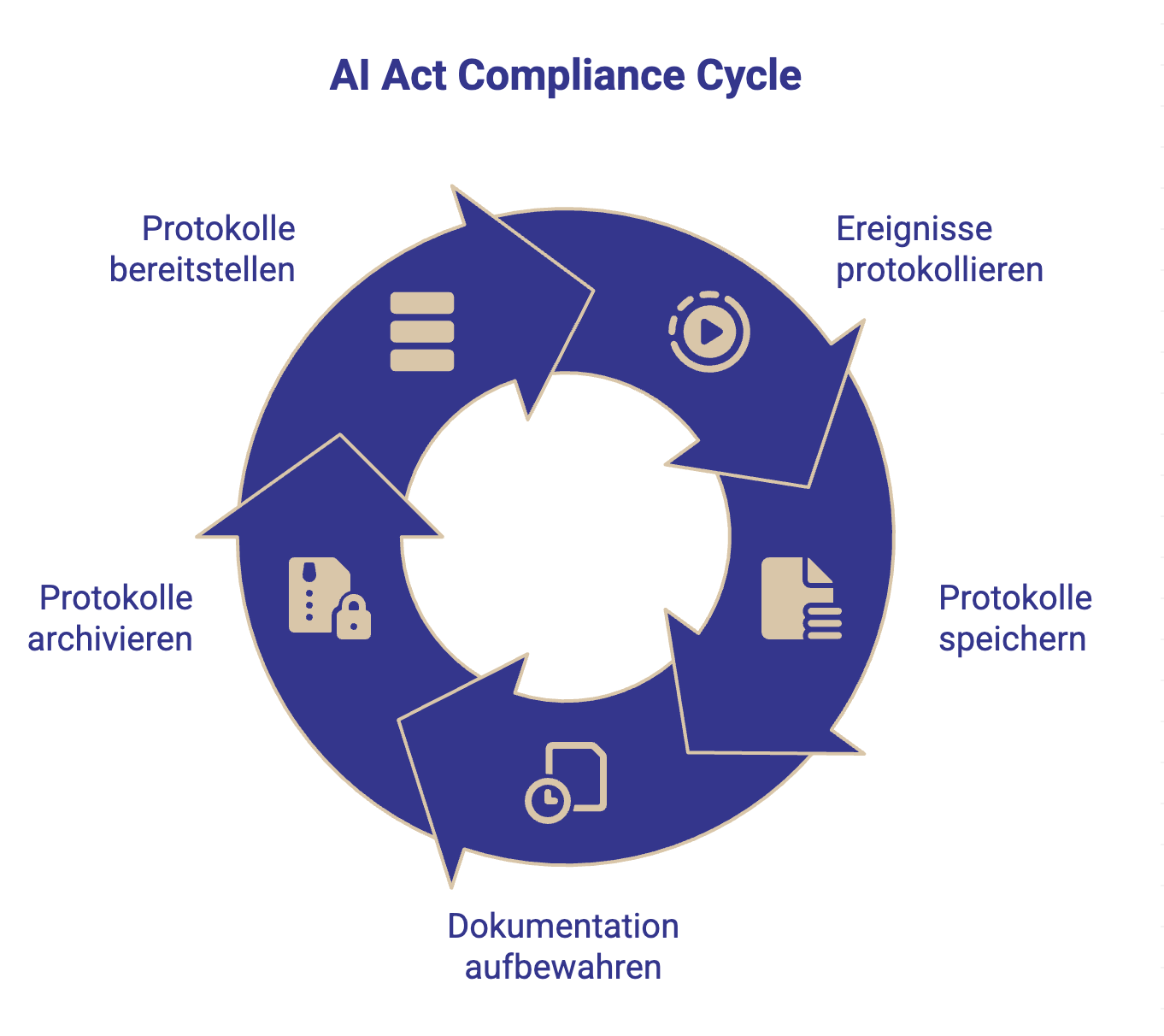

Protokollierung und Log-Aufzeichnungen (Art. 12, Art. 19)

Neben der schriftlichen Dokumentation schreibt der AI Act vor, dass Hochrisiko-KI-Systeme bestimmte Ereignisse und Outputs automatisch protokollieren müssen. Beispielsweise sollte ein KI-System zur Kreditwürdigkeitsprüfung mitloggen, welche Eingangsdaten zu welcher Ausgabentscheidung geführt haben. Diese Logs dienen der Nachvollziehbarkeit einzelner Entscheidungen im Nachhinein. Artikel 12 regelt, dass solche Aufzeichnungen integraler Bestandteil des Systems sein müssen – also möglichst automatisiert im laufenden Betrieb erzeugt werden.

Für Betreiber (User) von Hochrisiko-KI besteht dann gemäß Artikel 26 Abs. 6 die Pflicht, die vom System erzeugten Protokolle für mindestens 6 Monate aufzubewahren. Nationale oder europäische Datenschutzgesetze (z.B. DSGVO) können ggf. noch längere Speicherfristen vorschreiben oder – falls die Logs personenbezogene Daten enthalten – zusätzliche Anforderungen mit sich bringen. In jedem Falle sollte ein Unternehmen, das KI einsetzt, klare interne Prozesse haben, wie Logs gesichert und archiviert werden.

Artikel 19 der KI-VO schreibt ergänzend vor, dass Anbieter die gesamte technische Dokumentation und die Logs für Prüfzwecke bereithalten und ebenfalls 10 Jahre lang aufbewahren müssen. Das bedeutet: Nicht nur die "statische" Beschreibung, sondern auch relevante Laufzeitdaten aus dem Betrieb sind langfristig zu sichern. Im Kontrast zur klassischen Software-Dokumentation (die oft mit Auslieferung endet) betont der AI Act damit die Verantwortung über den gesamten Lebenszyklus eines KI-Systems.

Konformitätsbewertung, EU‑Datenbank & CE‑Kennzeichnung

Bevor ein Hochrisiko-KI-System überhaupt genutzt oder verkauft werden darf, muss der Anbieter eine Konformitätsbewertung durchführen und dokumentieren. Dies Prozedere ist vergleichbar mit dem CE-Zertifizierungsprozess bei klassischen Produkten: Es soll sichergestellt werden, dass das KI-System alle einschlägigen Anforderungen der KI-VO erfüllt, bevor es in Verkehr gebracht wird.

Konkret verlangt Artikel 43 der Verordnung, dass der Anbieter entweder intern prüft (für viele KI-Systeme vorgesehen) oder – in bestimmten Fällen – eine benannte Stelle (eine externe Prüforganisation) einschaltet. Das Ergebnis ist eine EU-Konformitätserklärung (Anhang V KI-VO), in der der Anbieter formell zusichert, alle Pflichten (Risikomanagement, Dokumentation, etc.) eingehalten zu haben. Erst danach darf die KI mit einer CE-Kennzeichnung versehen werden.

Die CE-Kennzeichnung signalisiert Konformität und ist bei Hochrisiko-KI ebenso Pflicht wie etwa bei Maschinen oder Elektronik.

Registrierung in EU-Datenbank

Zusätzlich schreibt der AI Act vor, dass Hochrisiko-KI-Systeme in eine zentrale EU-Datenbank eingetragen werden müssen, sobald sie auf den Markt kommen. In diesem Register (verwaltet vom zukünftigen Europäischen KI-Büro) werden Informationen zum System, zum Anbieter, intended purpose etc. hinterlegt. So können Behörden, aber auch die Öffentlichkeit, nachvollziehen, welche Hochrisiko-KIs im Umlauf sind.

Übergangsfristen

Der AI Act tritt gestaffelt in Kraft. Allgemeine Vorgaben (z.B. Schulungspflichten nach Art. 4) gelten ab Februar 2025, die meisten Hochrisiko-Pflichten (inkl. Konformitätsbewertung und Dokumentation) jedoch erst ab August 2026. Für KI-Systeme, die vor diesen Stichtagen in Verkehr sind, gelten teils Ausnahmen (Bestandsschutz), sofern keine wesentliche Änderung mehr erfolgt. Dennoch ist es für Startups ratsam, bereits jetzt compliance-fähige Prozesse aufzusetzen, da eine nachträgliche Anpassung teuer werden kann.

Sanktionen und Durchsetzung: Was droht bei Verstößen?

Die KI‑Verordnung setzt – ähnlich der DSGVO – einen hohen Sanktionsrahmen: je nach Verstoß bis 35 Mio. € oder 7 % des weltweiten Jahresumsatzes. Das Durchsetzungs‑Setup in Deutschland wird zentral koordiniert, branchenspezifische Rechtsvorschriften und Aufsichten (z. B. Finanzaufsicht) bleiben eingebunden – Kanzlei‑Analysen geben hierzu einen belastbaren Statusüberblick.

Unternehmensseitig drohen neben Bußgeldern Reputationsschäden und Projektstopps – ein weiterer Grund, Dokumentationspflichten und Bedingungen für sicheren Betrieb ernst zu nehmen.

Zur Orientierung für Unternehmen stellen zudem IHK‑Häuser strukturierte Informationen bereit, etwa der Überblick der IHK Osnabrück sowie der Ratgeber der IHK München.

Spezielle Herausforderungen für KI-Startups & Tipps

Für KI-Startups bedeuten die AI-Act-Vorgaben einerseits erhöhten Aufwand, andererseits bieten sie Chancen. Junge Unternehmen verfügen oft nicht über große Compliance-Abteilungen. Trotzdem müssen sie die Dokumentations- und Nachweispflichten erfüllen, um Marktzugang zu haben. Folgende Herausforderungen und Lösungsansätze sind zu beachten:

- Ressourcen & Prozesse: Die Erstellung belastbarer technischer Unterlagen kostet Zeit. Nutzen Sie Checklisten und Best‑Practice‑Vorlagen – etwa den Bitkom‑Umsetzungsleitfaden mit konkreten Prozessbausteinen, Rollen und Art.‑Bezügen. Für Sicherheits‑ und Risikomanagement‑Fragen liefert das Fraunhofer IKS‑Magazin Einschätzungen zur „KI‑Etikette“ und zur praktischen Umsetzung in KI‑Modellen.

- Know‑how & Schulung: Laut Artikel 4 AI Act müssen Unternehmen dafür sorgen, dass Mitarbeiter über ausreichende KI-Kompetenz verfügen. Für Startups ist dies kritisch – oft sind Tech-Teams top, aber im Regulatorischen unerfahren.

Tipp: Frühzeitig Weiterbildungen einplanen oder externe Expertise hinzuziehen. Es entstehen neue Rollen wie "KI-Beauftragter", ähnlich dem Datenschutzbeauftragten. Einige Dienstleister bieten bereits an, Unternehmen als externer KI-Compliance-Officer zu unterstützen. Das kann überbrückend sinnvoll sein, bis intern das Wissen aufgebaut ist.

- Agilität vs. Regulierung: Startups iterieren ihre Produkte schnell. Ständige Änderungen kollidieren mit der Pflicht zur Dokumentationspflege.

Tipp: Integrieren Sie Compliance in Ihren DevOps-Prozess. Zum Beispiel kann jede neue Version automatisch einen Compliance-Check triggern. Durch Automation (etwa Tools, die Änderungen im Code erkennen und an die Dokumentationsverantwortlichen melden) bleibt man trotz agiler Entwicklung konform. - Vertrauensvorsprung nutzen: Ein transparent dokumentiertes KI-Produkt kann aktiv vermarktet werden. Zeigen Sie Kunden, dass Ihr System geprüft und "AI Act ready" ist. Da die Verordnung EU-weit gilt, schaffen Sie sich so einen Wettbewerbsvorteil gegenüber Konkurrenten, die evtl. zögern, die strengen Vorgaben umzusetzen.

- KI-Reallabore: Eine gute Nachricht für Startups ist die Einführung von Regulatory Sandboxes. Der AI Act fordert die EU-Länder auf, "KI-Reallabore" einzurichten. In solchen Reallaboren können Startups ihre KI-Lösungen zeitlich begrenzt in einer kontrollierten Umgebung testen, ohne alle Pflichten sofort erfüllen zu müssen. Die Erfahrungen aus dem Labor sollen helfen, das System zu verbessern und compliance-fit zu machen, bevor es offiziell auf den Markt kommt.

Fazit zu AI Act Hochrisiko Systemen

Die EU-KI-Verordnung bringt Hochrisiko-KI-Systemen strenge, aber handhabbare Pflichten. Insbesondere die Dokumentationspflichten – von der technischen Dokumentation über Logfiles bis zur Nutzerinformation – zielen darauf ab, Transparenz und Vertrauen in KI zu schaffen. Für KI-Startups bedeutet dies zwar zusätzliche Arbeit, doch langfristig auch Qualitätsgewinne: Ein sauber dokumentiertes, risikogemanagtes System ist zuverlässiger, sicherer und marktfähiger.

Unternehmen sollten die Übergangszeit bis 2026 nutzen, um Compliance "by Design" zu verankern. Wer früh die richtigen Weichen stellt – interne Kompetenz aufbaut, Prozesse etabliert und ggf. Sandbox-Angebote nutzt – kann die KI-VO nicht nur erfüllen, sondern daraus einen Wettbewerbsvorteil ziehen. Am Ende zahlt es sich aus, KI verantwortungsvoll und gesetzeskonform einzusetzen: Es schützt die Nutzer, das eigene Unternehmen vor Sanktionen und stärkt die Innovationsfähigkeit im Vertrauen der Öffentlichkeit.

Nächste Schritte – Ihr Vorteil mit ODC Legal

Als Ihre externe Rechtsabteilung begleiten wir Sie von der Einstufung über die Dokumentationsarchitektur bis zur CE‑Konformität – inklusive Review Ihrer Risikomanagement‑ und Logging‑Prozesse. Haben Sie Fragen zu diesem Thema? Vereinbaren Sie jetzt Ihr persönliches Erstgespräch mit ODC Legal. Wir sorgen für Rechtsklarheit – damit Ihre KI‑Lösung schnell, sicher und compliant skaliert.

Jetzt Erstgespräch sichern – Ihre KI rechtssicher und CE‑konform skalieren

FAQ – Häufig gestellte Fragen zu Hochrisiko-KI und Dokumentationspflicht

Was sind KI-Systeme mit hohem Risiko?

Als hochriskant gelten KI-Systeme, die ein erhebliches Gefahrenpotenzial für Gesundheit, Sicherheit oder Grundrechte haben. Der AI Act nennt dazu zwei Gruppen: (1) KI-Komponenten in regulierten Produkten (z. B. KI in Medizinprodukten, Fahrzeugen) und (2) KI-Anwendungen in sensiblen Bereichen wie Biometrie, kritische Infrastruktur, Bildung, Beschäftigung, Kreditvergabe, Strafverfolgung, Asyl/Migration oder Justiz. Diese Systeme dürfen nur betrieben werden, wenn sie strikte Vorgaben erfüllen, weil Fehlfunktionen gravierende Folgen haben könnten.

Ist Chatgpt ein Hochrisiko-KI-System?

ChatGPT selbst ist als General Purpose AI (allgemeine KI für verschiedene Zwecke) zunächst nicht per se als Hochrisiko eingestuft. Entscheidend ist der konkrete Einsatzzweck: Wird ChatGPT in einem Hochrisiko-Kontext verwendet (z.B. als Tool für automatisierte Personalentscheidungen oder medizinische Diagnosen), können die Hochrisiko-Vorgaben greifen. Der AI Act unterscheidet zwischen Anbietern von Foundation Models (wie OpenAI) und Betreibern, die diese Modelle in spezifischen Anwendungen einsetzen. Foundation-Model-Anbieter haben eigene Transparenzpflichten, aber die volle Hochrisiko-Regulierung trifft denjenigen, der das System in einen sensiblen Bereich integriert.

Social Scoring vs. CRM

Im Online-Marketing ist es üblich, Daten zu nutzen, um Zielgruppen besser anzusprechen. KI-gestütztes Targeting oder ein gutes CRM-System helfen, Kundenerlebnisse zu personalisieren und Budgets effizienter einzusetzen.

Doch wo hört sinnvolles Marketing auf – und wo beginnt das verbotene Social Scoring?

Beim Targeting oder Customer-Relationship-Management (CRM) werden Kundendaten genutzt, um relevante Inhalte oder Angebote zu erstellen.

Die Grundlage ist dabei immer Transparenz, Zweckbindung und Fairness.

Beispiele:

- Ein Online-Shop zeigt Sportfans gezielt Laufschuhe an.

- Ein Newsletter-Tool segmentiert Empfänger nach bisherigen Käufen.

- Ein CRM speichert Kundenanfragen, um Support und Follow-ups zu verbessern.

Diese Anwendungen sind legal und erwünscht, solange:

- Kundinnen und Kunden wissen, dass ihre Daten zu Marketingzwecken genutzt werden.

- keine sensiblen Daten (z. B. Religion, Gesundheit, politische Meinung) verarbeitet werden.

- die Daten nur innerhalb des eigenen Geschäftszwecks eingesetzt werden.

Ziel: bessere Kundenerfahrung – nicht Bewertung des Menschen.

Beim Social Scoring geht es nicht mehr um Service oder Marketing, sondern um Bewertung und Kontrolle von Menschen.

KI-Systeme, die Verhalten, Lebensstil oder Meinungen auswerten, um soziale oder wirtschaftliche Vorteile oder Nachteile zu vergeben, sind explizit verboten.

Typische Merkmale:

- Menschen werden auf Basis von Online-Daten oder Verhalten bewertet oder gerankt.

- Diese Bewertung beeinflusst Entscheidungen außerhalb des ursprünglichen Kontexts (z. B. Job-, Kredit- oder Wohnungsangebote).

- Die Kriterien sind nicht transparent oder nicht nachvollziehbar.

Beispiel:

Ein Unternehmen kombiniert Social-Media-Posts, Einkaufsverhalten und Standortdaten, um den „Zuverlässigkeitswert“ eines Kunden zu berechnen. Wer unter einem bestimmten Score liegt, bekommt keine Premium-Angebote.

→ Das ist Social Scoring – und nach der EU-KI-Verordnung verboten.

Welche Pflichten haben Anbieter von Hochrisiko-KI-Systemen?

Anbieter müssen ein umfassendes Maßnahmenpaket umsetzen. Kernpflichten sind ein Risikomanagement-System, sorgfältige Datenaufbereitung, eine ausführliche technische Dokumentation des KI-Systems sowie automatische Protokollierung der Systemaktivitäten. Außerdem müssen sie eine Gebrauchsanweisung für Anwender bereitstellen, menschliche Überwachung sicherstellen (inkl. Notabschaltung) und das System vor dem Einsatz einer Konformitätsbewertung unterziehen. Erst nach erfolgreicher Prüfung und Registrierung darf das System mit CE-Kennzeichnung in Verkehr gebracht werden.

Wer muss die Dokumentationspflicht nach AI Act erfüllen – der Hersteller oder der Nutzer?

Vor allem der Anbieter (Hersteller/Entwickler) eines Hochrisiko-KI-Systems ist für die Erstellung der technischen Dokumentation verantwortlich. Er muss diese Unterlagen schon vor dem Inverkehrbringen fertigstellen und bei Bedarf Behörden vorlegen können. Betreiber (Nutzer) haben geringere Pflichten, müssen aber u.a. die vom System erzeugten Logs aufbewahren und das System gemäß der mitgelieferten Anleitung einsetzen. Betreiber im Arbeitskontext (Arbeitgeber) müssen zudem Mitarbeiter informieren, wenn eine Hochrisiko-KI am Arbeitsplatz eingesetzt wird.

Ab wann gelten die neuen KI-Regeln und Dokumentationspflichten?

Der AI Act wurde 2024 verabschiedet. Viele Vorgaben treten mit einer Übergangsfrist in Kraft: Allgemeine Pflichten (z.B. Schulungen, Verbot bestimmter KI) gelten ab 02. Februar 2025, während die meisten Anforderungen für Hochrisiko-KI (einschließlich Dokumentationspflichten) ab 02. August 2026 wirksam werden. Einige spezielle Pflichten (für bereits regulierte Produkte, Anhang I KI-VO) greifen erst 2027. Unternehmen sollten die Deadlines nutzen, um bis 2026 ihre Prozesse anzupassen. Wichtig: Bereits vor Geltungsbeginn in Verkehr gebrachte Hochrisiko-KI können unter Bestandsschutz fallen, sofern sie bis dahin nicht wesentlich geändert werden.

Brauchen KI-Systeme jetzt eine CE-Kennzeichnung?

Ja, für Hochrisiko-KI-Systeme ist eine CE-Kennzeichnung vorgeschrieben. Der AI Act verlangt analog zu bekannten Produktvorschriften, dass der Anbieter nach erfolgreicher Konformitätsbewertung eine EU-Konformitätserklärung erstellt und das KI-System mit dem CE-Zeichen versieht. Dies signalisiert, dass das System alle AI-Act-Anforderungen erfüllt. Die CE-Kennzeichnung für KI ist neu und ergänzt bestehende CE-Pflichten: Falls ein KI-System Teil eines CE-pflichtigen Produkts (z.B. Medizinprodukt) ist, muss künftig beides erfüllt sein. Nicht-hochriskante KI-Systeme (begrenztes oder minimales Risiko) benötigen keine CE-Kennzeichnung nach AI Act, da für sie keine Konformitätsbewertung verlangt wird.

Vereinbaren Sie jetzt Ihr Erstgespräch

Erfahren Sie, wie wir Ihnen helfen können und erhalten Sie wertvolle rechtliche Beratung.

.jpg)

.webp)